MLE, MAP和EM算法

一年多没有动过这里, 最近发现由于疏于管理纸质版笔记, 学习过程中很多做的笔记都找不到…所以最近开始准备把一些基本的笔记总结做在博客上!!! 第一篇博客就挑容易理解的东西记, 最近在课上学习了MLE, MAP和EM算法, 这里唠嗑一遍, 这篇文章关于MLE和MAP都是一些总结性的描述和想法, 没有什么数学公式和干货hhh。后面的EM还是写了几个公式.

MLE

MLE(maximum likelihood estimation)是一种从数据中做参数估计的概率方法, 基本是这么个想法:

问题$P$和数据集$D$给出。问题$P$经常有现实中用来衡量某一个模型$M$的好坏的objective: specialized objective, 也有很多可以reasonable的人造的objective, 但是我们由于很熟悉概率模型, 熟悉MLE technique, 所以我们决定要用probability intepretion建模这个问题, 建模分为模型形式和优化目标:

- Model: 假设产生数据集$D$的模型, 也就是从要估计的参数$\theta$生成$D$的概率分布。这个model中要结合具体任务以及人类domain-specific的知识, 并适当加入一些简化的假设。模型按照其建模的关系不同分为两类:

- generative probabilistic model: $D = {x}$ 可以假设出 $P(x|\theta)$ 的形式。可用于有监督学习(function estimation)或者无监督学习(density estimation)。

- discriminative probabilistic model: $D = {(x, y)}$, 做完参数估计之后的主要任务是估计$\hat{y} = \hat{f}(x)$, 也就是有监督学习做prediction, 任务就是function approximation。给定可以假设出$P(y|x, \theta)$的形式。主要用于有监督学习(function estimation)。

- Objective: 用probabilistic intepretion建模问题后, 原问题的objective可能不是那么好处理, 我们比较喜欢training set (conditional) likelihood这种objective来训练/fit 我们的probability-based model $M$.

具体一个问题要怎么建模有很多套路, 举几个例子:

- 套路1: 指数族分布, 指数族分布有很多好的性质, 特别是在训练集经常是i.i.d的监督/非监督学习中, 也有Systematic的解决方法研究。我了解的并不多, 现在来说, 总结采取指数族分布作为generative model或者discriminative model建模训练数据的好处:

- 很明显看出, 由于因子分解定理, 指数族分布里的$T(x)$为样本集$x$的一个充分统计量, 那么$\eta$肯定只会是充分统计量, 也就是$T(x)$的一个函数。

- 在i.i.d采样的样本集里的充分统计量是所有单个样本充分统计量$T(x)$的和, 这个从指数分布的形式就可以看出来。

- 指数族分布的log likelihood关于自然参数$\eta$是一个凹函数, 首先$\eta$的parameter space肯定是convex set(不难证明), 然后满足$\frac{\partial L}{\partial \eta} = - \nabla^2 A(\eta) = - Var(T(X))$. 即log likelihood关于$\eta$的二阶导数为样本随机变量X的充分统计量$T(X)$的variance, 肯定大于0. 也就是说, 给定任意一个数据集$D$, 指数族分布的MLE解(即为最大化)是唯一的, 且在$\frac{\partial L}{\partial \eta} = T(x) - \nabla A(\eta) = 0$, 即MLE矩参数估计$\hat{\mu} = T(x)$处取得。

- 注意上面的解释中, 用到了指数族分布的log-normalizer $A(\eta)$方便的moment generating property, 这个不难证明. 写在这篇总结的最下面, 感觉应该挑一个专门的博客来总结Exponential family distribution和GLIM相关的东西.

- 将指数族分布的模型适配应用到各类问题上的实践十分多, 即使没有MLE closed form的解 经常用的local optimization方法所用的gradient也有固定的形式: $\frac{\partial L}{\partial \eta} = T(x) - \mu$, 用这个gradient(可能加上正则化之类的)做下降法。

- 比如概率图模型里的应用: eg. CRF, 这是一个discriminative的model, 采取y概率图模型建模条件分布 $P(Y|X)$, 无向图模型本身就表示gibbs distribution, 所以要再把这一系列factorize在这个无向图模型上的概率分布限制在指数族分布族里很简单, 只要再假设设每个factor都是一个local feature点积上feature参数的exp即可。在这个模型中, 统计量为各个x和某些y之间的local feature, 由于这个问题space大, 模型复杂, 没有一个closed form的normalizer的形式, 不能得到closed form的解. 所以会用likelihood loss的梯度下降做优化。其中T(x)直接就是各组训练数据的feature相加, 容易求。但是每次$\mu$的求解都是要解$E_{P(Y|X)}[F(Y, X)]$的一个inference problem, 这就要带入概率图模型里的inference problem的算法了. 这个例子好像坑有点大…

- 套路2: generative model中feature之间的独立性假设: 首先还是要考虑现实情况, 这个特定的task用独立性假设是不是完全不科学. 如果还是可能可以接受的, 在训练数据少的时候, 利用独立性假设的模型由于参数更少, 会收敛更快, 更不容易overfitting.

- 在模式识别第一次作业的实验中, naive bayes的效果比softmax regression(logistic regression多分类推广)的效果好不少. 而且基本没有hyper parameter需要调整.

MAP

上面提到了加入一些独立性假设, 让参数量变小, model complexity变小, 可以缓解overfitting. 这是从模型结构上来降低model complexity。另一种思路防止训练数据量太小时, 参数过拟合, 是从对参数引入修正或者先验出发的。为参数引入修正, 我指的是一些参数的regularization方法, 比如加入L1, L2 regularizer(regularization是一个集各种empirical trick为一体的大话题, 这个需要单开blog总结)。而为参数引入先验, 则可以防止参数估计在训练数据量小时, 由于几个outlier(噪声很大的样本)的存在, 有很大的误差。(实际上加入Baysian先验也常被归类为regularization的一种. 在做MLE训练时加入各种L1, L2 regularizer, 也可证明与加入某种参数的Baysian先验再做MAP是等效的(Laplace or Gaussian))

当我们为要估计的参数引入先验分布, 并且用参数的最大后验概率准则来估计参数时, 这就是贝叶斯方法。贝叶斯方法的核心在于: 把参数也作为随机变量, 如果画成概率图形式, 贝叶斯方法相当于把参数也作为一个节点画在图里, 每个不同的参数的取值会导致训练样本 $X$ 的不同CPD(conditional probability distribution)。这样我们就把参数估计也统一到随机变量的inference框架(inference中的一类问题就是求条件概率嘛)里来了!

在MAP中怎么取prior分布的形式也有常见的套路和典型例子, 共轭先验(conjugate prior)是在贝叶斯MAP估计中经常用的取参数先验分布形式的方法。一族似然函数的共轭先验分布族的定义如下:

给定似然函数族, 使得参数的后验分布和其先验分布为同一族分布的分布族称为该似然函数的共轭先验。

WIKI里列出了很多常见似然函数形式对应的共轭先验。

总的来说, 假设参数先验为共轭先验的一个很突出的优点是计算的方便性。对于这个问题的理解可以从几个角度看:

-

计算角度: 如果不取共轭先验, 后验概率的normalizer很可能得不到closed-form解, 而取共轭先验时, 参数后验概率仍然和先验概率形式相同, 只是超参数不同, normalizer可以直接用超参写出来, 其实不需要计算, 很容易得到后验概率的closed-form形式。此时基于参数$\theta$的后验概率的MAP估计就是简单的取该后验概率的mode, 是一个分布超参数$\alpha$的函数。

-

观测数据逐渐调整参数分布的超参数: 可以将观测数据增加的过程, 看作是对先验分布超参数的一个逐渐调整的过程! 也就是说, 如果已经观察到$n$个数据, 得到一个参数$\theta$的后验分布$P$, 从此之后的新数据来得时候, 现在的后验分布$P$完全可以看作先验分布, 这意味着什么: 之前的观察数据在用其统计量达成对先验分布超参数的调整任务后, 可以完全丢掉, 不需要重新拿出来了! 这样的性质应该在online-learning中会比较有用吧(我猜)…

-

伪观测数据(pseudo observation): 自然的, 从上面一个角度反过来看, 既然观测数据可以看作是对共轭先验的超参数的逐步调整, 那么也可以把共轭先验看作是一堆伪观测数据造成的结果! eg. naive bayes模型做文档分类的具体问题时, categorical/multinomial likelihood对应的是Dirichlet分布为其共轭先验, (Dirichlet分布为一个定义在n维概率simplex(所有维非负且和为1)的一类分布), multinomial中每个category $i$对应的超参数$a_i$相当于是给该类别增加的观察到的伪数据。对称Dirichlet分布中所有$a_i$相同, 又叫concentration parameter, 因为该超参数$a$越大, 代表我们先验的越相信所有参数$\theta_i$都应该差不多大, 而该超参数越小代表我们认为这些参数$\theta_i$之间可以差很远(某种意义上强调了参数集合$\theta_i$稀疏性)。而最大先验概率$\theta_i$之间的相对大小由$a_i$的相对大小决定(加个lagranian约束求个导就可以推到: 成正比)。在这种基于Bag-of-word模型的分类问题里经常是需要避免zero-probability问题, 加入Dirichlet共轭先验与做一个laplace smoothing等价,其实就是引入了伪观测数据。

从上面的分析可以看出来, Bayesian MAP estimation是结合了从psedo observation和实际的observation的充分统计量来做估计, 而之前的MLE只用到了实际observatoin的充分统计量。在实际观测数据量足够大时, 先验对后验所造成的影响慢慢被实际观察数据的统计量遮掩掉, MAP估计趋近于MLE估计。

EM算法

问题

在做观察到所有数据(complete data)且模型中不做隐变量假设的MLE估计的时候, 给定i.i.d数据集$D = {(x^{(i)})}_{i=1,…,N}$, 我们要优化的training set log likelihood可以写为

对于log函数的求导我们驾轻就熟, 这个MLE问题对于不少模型也很好解。但是如果问题中有未观察到的变量, 或者说我们的模型中引入了其它的隐变量$Y$呢。我们还是只能观察到随机变量$X$的各个sample, 但是我们概率模型建模的确是包含隐变量的联合分布 $P(X=x, Y=y | \theta)$, 那么现在我们要优化的training set log likelihood变成:

NOTE: 若隐变量$y$连续, log里面的求和号变为积分号。

这个问题我们还是用MLE去怼的话:

log里面有求和和积分, 这个事情一下子就变得复杂了, log求导之后, 在分布的项可能把所有$\theta$的分量都couple在一起。比如: 如果我们本来取的模型是指数族分布的话, complete data无隐变量的MLE的形式会被大大化简, 参数的各维度都是解耦合的(把指数族分布形式代入MLE式子既知)。但是即使这里 $P(X,Y|\theta)$ 为指数族分布所有的参数维度也都还是couple在一起。而且log likelihood瞬间就不一定是凹函数了。这要怎么办呢? 第一个想法, 就不要建带隐变量的模型不行吗? 这个很难做到, 现实中很多问题的性质需要引入隐变量才能有效结合先验知识(比如这些数据是某种混合模型产生的), 或者本身问题的定义就存在隐变量。好吧, 那这个优化问题还是要解。

第二个想法: 不能analytical得到MLE估计? 可能非凹函数? 梯度下降嘛, 局部优化打天下, gradient descent, newton-raphson用上去! 当然能用啊, 连Loss函数形式都没有都能用! 在一些特殊情况下gradient descent算法和EM算法是可以相互转换的: eg. 在GMM问题中, EM算法的效果和某种变种的gradient descent是等效的. 和后面讲的EM算法不同的是: gradient descent或者二阶方法要求求出gradient或者Hessian等。

EM算法导出

实际想总结的想法: EM算法. 下面只从我浅薄的理解来讲, 这个问题的难点在于log里面有求和/积分号, 那考虑一个简单一点的问题, 能不能通过适当的放缩这个问题把log里面的求和/积分号去掉呢。这里就要用到凸优化里面的Jensen不等式, 对于一个凹函数f(eg. log):

这个不等式很好理解, 凹函数的定义就是, $f: R^n \rightarrow R$, $\mbox{dom} f$为凸集, 且$\forall y_1, y_2 \in \mbox{dom} f, \forall \theta_1, \theta_2 \in R_{+}, \mbox{s.t.} \theta_1 + \theta_2 = 1, \mbox{we have } \theta_1 f(y_1) + \theta_2 f(y_2) \leq f(\theta_1 y_1 + \theta_2 y_2)$. 这个不等式可以推广到多项求和或者积分, 也可以写成上面的那个不等式形式。

这个不等式显然能把log里面的求和放缩到log外面的求和, 但是要构造出一堆加起来为1的系数, 设这组index为$y$的系数为$q(y)$, $q(y)$可以看作$Y$的任意一个概率分布。OK, 到现在我们得到了我们想最大化的函数的一个下界(下面推导为了方便起见只对i.i.d训练集中的一项做):

这个下界成功实现了我们想要的把log里面的求和去掉的目的, 自然的该下界对 $\theta$求偏导做MLE已经基本转换到了原来的MLE问题了。如果取模型$P(X, Y|\theta)$为一个指数族分布, 我们知道一个凹函数的非负加权和仍然是凹函数, 这个问题就是一个凸优化问题, easy!

现在问题来了, 优化下界固然是对原问题有用的, 毕竟原问题至少也要比下界的最优解更好, 但是是否能在$q(y)$取某个值的时候Jensen不等式取到等号, 并且这个值是多少呢? 这个其实很容易啦, 回到刚刚用于构造出Jensen不等式的凹函数log来考虑, 对于一个严格凹函数(eg. log), 如果要Jensen不等式取等号, 只有可能所有的点$y_i$都一样, 代入这个问题意思就是:

一般遇到这种关系式, 求解方法当然是利用$\sum_y q(y) = 1$的关系把Const推出来: $\mbox{Const} = P(x)$。再代入回去:

也就是说在$\theta$固定时, 将$q(y)$取作$Y=y$在$x$固定下的条件概率即可使Jensen 不等式取到等号。也就是在固定$\theta$只调整$q(y)$的情况下, 最大化$F(\theta, q)$可以显式计算出$q(y)$, 不需要解最大化问题。

解出$q(y)$再代入回去$F(\theta, q)$后原来的$\theta$已经不是最优的了, 那么又要继续优化$\theta$. 相当于我们需要循环优化$q$和$\theta$两组参数。

NOTE: 实际计算, 对于各种混合模型, 要求 $P(Y = y | x, \theta)$, 只要求出对于每个$y$的$P(X=x, Y=y|\theta)$, 然后加起来作为分母就行了。

这个计算 $q^{t}(y) = P(Y = y | x, \theta^{t-1})$, 然后得到新的下界函数$F(\theta, q^{t})$的过程一般称为EM算法中的Expectation-step。诶这不是一个优化$q(y)$最大化$F$的问题嘛? 为啥叫expectation-step, 之所以叫做expectation, 是因为: 设$F(\theta,q) = Q(\theta, q) + H(q)$, 那么新的Q函数如下:

其中$\theta^{t-1}$为用于计算$q(y)$的上一次循环的$\theta$.

EM算法中的Maximization-step即为固定$q(y)$优化$\theta$最大化下界函数, 也就是优化该只关于$\theta$的函数$Q(\theta, \theta^{t-1})$:

正确性

很容易可以看到EM算法估计出来的$\theta$在每一步是一定不会让$L(\theta)$变小的:

第一个不等号为Jensen 不等式, 第二个不等号为M-step所做的事情, 第三个不等号为E-step所做的事情。但是即使每一步M-step都得到下界函数的全局最优解, EM算法还是可能卡在鞍点或者局部最优。而且EM算法general的情况下, 并没有收敛性的保证。

讨论

GEM

一个小改进Generalized EM: 可能M-step中的下界优化问题也不是那么好求全局最优解, 或者E-step中的条件概率inference问题也不好解, 那么这两个优化问题中都可以考虑不解全局最优解, 而是都保证$F(\theta, q)$在increase即可。

the more “informative” the missing data is, the slower the convergence

收敛到局部最优的改进

比如random-restart hill climbing, 或者模拟退火这些常用的试图逃离local minimum的很emiprical的搜索算法。

baysian view

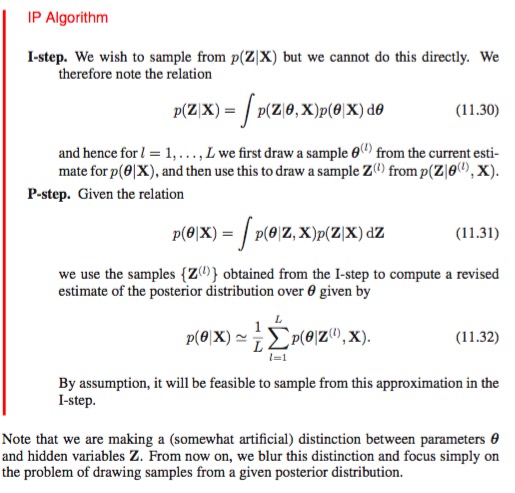

与MAP里面的baysian view类似, 把参数$\theta$也作为node画在图里, 也就是为$\theta$引入prior distribution, 从MLE点估计到后验概率估计。EM算法中Expectation step对隐变量$Y$估计的是后验概率 $q(y) = P(Y|X)$ , 而在Maximization step对$\theta$只做点估计,在Bayesian view of EM algoirthm中M-step对$\theta$也是估计后验概率. 这样统一化两种step。下图摘自PRML2006版p537(其中每个Expectation/积分的计算还用到了Monte carlo sampling(也可以用Variational inference给 $P(Z,\theta |X)$ 一个factorized形式然后也是对$Z$和$\theta$做alternating更新):

用baysian view, 把$\theta$也统一到需要估计后验概率的隐变量$Y$里。上面的note中也提到了用baysian view, $\theta$和latent variable $Y$统一了, 上面只是故意人工区分了两部分variable, 实际上这两部分variable都是latent variable, 优化顺序也可以调整。现在要做的事情就只有求$P(y|x)$了(没有所谓的求$\theta$的点估计来maximize log-evidence$L(\theta)$了)。

一般来说mixture models里表征是哪个mixture的隐变量还能大多数都是离散的, 但是分布参数$\theta$也作为隐变量(通常连续空间)之后, $P(Y|x)$一般就不那么好求了, 那怎么近似计算$P(y|x)$呢? 讨论看下面一节。

连续空间的隐变量

在刚刚的推导过程中, 有一个细节没有提, E-step中我们认为$P(Y|X)$是可以算出来的,而且是通过对每个$Y$的可能取值秋$P(Y|X)$, 然后加起来作为normalization。如果$Y$是连续空间的随机变量或者$Y$包含了多个离散随机变量(space随变量个数指数增长),随机变量的取值空间太大: 求出每个$y$的值然后加起来作为分母来求条件分布, general来说很难算, Q函数$Q(\theta, \theta^{t-1}) = E_{P(Y|X,\theta^{t-1})}[log P(X, Y| \theta)]$是一个对我们觉得很难采样甚至很难得到的概率$P(Y|X)$的期望, 这个expectation很难算。

所以, general的EM算法好用情况, 都是隐变量$Y$为离散取值的随机变量(比如mixture model嘛)。不过, 如果$P(X, Y)$为某些特定分布, 也可以用一些特殊的结论, 比如multivariate联合高斯分布, 其中一部分变量条件在另一部分变量上的分布仍然是高斯分布, 并且参数能够用原分布的参数analytical的写出来。比如模式识别EM算法作业的第三题就是这样一个特例。

如果实在不是这两种类型, 不但latent variable $Y$的space太大(特别是用了Baysian view之后$\theta$的先验和likelihood又不是conjugate的时候更难求)不好求normalize,而且$P(Y|X, \theta^{t-1})$也不是analytical可以得到的, 那么就要用aproximiated inference的方法, 假设关心的概率$P$虽然不好得到, 但是其unormalized form $P(X, Y | \theta^{t-1})$确实比较好得到:

- MC: 可以用一些Monte carlo采样的方法来得到Q函数(还没用baysian view)或者后验概率$P(Y|X)$/$P(\theta|X)$(见prml_mc_em的例子, 就是用MC采样alternating对不同latent variable $Y_i$ 估计$P(Y_i|X)$, 这里已经用baysian view所以不估计Q函数了): 一个相对于后验概率的期望, 不少MC方法的好处在于可以在已知关心的概率$P$的unormalized形式$\tilde{P}$的时候(比如$P(Y|X)$的unormalized概率可以取$P(X ,Y)$)得到相对于该概率的expectation。

- i.i.d的方法有likelihood sampling(BN)/general importance sampling, 看proposal的点$x’$的proposal distribution $\tilde{q}(x’)$ 和 $\tilde{P}(x’)$的比例;

- Markov-chain based 的MCMC方法: 比如metropolis hasting一也不需要normalize term的, 看proposal的点$x’$和当前的点$x$unormalize prob $\tilde{P}$的比例: $\tilde{P}(x’)/\tilde{P}(x)$做transition.

- 结果: 得到$P(Y|x)$的渐进无偏估计

- VI: deterministic approximation, 对$P(Y|X)$的近似分布形式$q(Y)$引入限制使得$q(Y)$可解, 假设一族分布$q(Y)$可以用来近似$P(Y|X)$, $q(Y)$经常假设为可以factorize成disjoint factor乘积的一族分布、或者由参数决定的一族某种分布。在这族分布中调整$q_\lambda(Y)$使得得到的$q_{\lambda^{*}}(y)$与$P(y|x)$最接近. 使用KL divergence衡量$q(Y)$和$P(Y|x)$相似度。(传统VI方法里最常见的是mean-field variational Bayes, 考虑一族factorized的分布族,然后用coordinate descent的方法analytical的更新每个factor并iterate。)

考虑之前得到的下界$F$和log-evidence $L$之间的差, 有:

对于一个任何一个$q(Y)$, log-evidence $L$固定(与$q(Y)$无关), 要让下界最接近这个固定的evidence, 就是要调整$q(Y)$最小化$L - F = KL[q(Y) || P(Y|x)]$. 也就是最大化下界$F = E_{q(y)}[\log \frac{P(X, Y)}{q(y)}]$。具体解的过程参见PRML或者wiki, 根据对$q(Y)$分布族的假设最大化这个下界$F$可以得到, $q(Y)$的多个disjoint factor的互相相关的形式和参数的方程组。对这个多个factor coupled的fix-point方程组里的各个disjoint factor alternating求解。解完之后我们得到了:

- $P(Y|x)$的一个估计$q(Y)$

- log-evidence的一个下界(可用来做model selection): $F = E_{q(y)}[\log P(X, Y)] + H[q(y)]$又称为(negative) variational free energy

可以看到两种方法都可以得到隐变量的后验概率 $P(Y|x)$

Monte Carlo techniques provide a numerical approximation to the exact posterior using a set of samples, Variational Bayes provides a locally-optimal, exact analytical solution to an approximation of the posterior

Variational Inference方法在generative model的发展中,可以看到已经给很多基于优化方法做模型学习的objective的设计提供了理论基础。最近几年的VAE, 把recognition network用在variational parameter的计算上, 用gradient优化方法ELBO(为了降低MC gradient估计variance,要用到reparametrization trick, baseline method, control variates等一系列方法)。 从另一个角度,VAE也可以看作是Auto-Encoder系列的一个发展: $F = E_{q(y)}[\log \frac{P(X, Y)}{q(y)}] = E_{q(y)}[\log P(X|Y)] - KL(q(y) | P(y))$中, 其中第一项是似然的期望, 当$ q(y|x)$用encoder network(recognition)建模时, 如果$P(x|y)$也是一个神经网络(decoder network), 那么第一项就类比为原来AutoEncoder的reconstruction term(要注意encoder和decoder中间加了stochastic sampling layer); 第二项是隐变量的variational distribution $q(y)$和隐变量先验$P(y)$的KL距离,这项就是一个regularization。

VAE工作的突破从两支看:

-

从VI出发: 采取follow gradient of ELBO的方法(而不是analytical的coordinate descent) * 用神经网络建模variational posterior, 不再是原来的每个数据点都有一组variational parameter需要做优化求得, 而是抽出一个神经网络(常称为recognition network)用于计算$q(y|x)$的variational parameter, 给定$x$, 就可以feed-forward的得到其对应的$y$的variational posterior的variational parameter, 所有数据共享神经网络的参数。 * incorporate variance reduction techniques. 让follow ELBO MC gradient的优化可行。

-

从autoencoder出发: 神经网络的backpropagation. 一旦要用follow gradient一类的优化方法, objective的设计就很重要了. 纯auto-encoder的时候我们很heurestic的用reconstruction error, 但是这种模型没有建模自然界的uncertainty, generative能力并不好, 需要一些建模uncertainty的方法, 在优化理论中我们称为regularization, 但是regularizaiton怎么设计呢? 有通过denosing AE, contractive AE这种heurestic的方法设计, 现在发展到了VAE的这种probablistic generative model的ELBO来设计。

性质

从wiki上摘录的: EM is especially useful when the likelihood is an exponential family: the E step becomes the sum of expectations of sufficient statistics, and the M step involves maximizing a linear function.

所以说如果一个问题有一些隐变量, 原问题直接求MLE很难, 而当这这些隐变量已知的时候做MLE优化十分简单的时候, EM算法有效。

proximal methods for optimzation

这一类算法也需要之后继续看. EM算法应该是这个算法框架中一种. 还没有看文章呢… https://arxiv.org/abs/1201.5912

附: 指数族分布的moment generating property性质证明

指数族分布的自然系数(natural parameter)表示形式为

其中$A(\eta)$称为log-normalizer. 现在要证明$A(\eta)$关于$\eta$的k阶偏导数为充分统计量随机变量$T(X)$的k阶累积量. (2阶累积量是方差, 3阶累积量是3阶中心矩)

我们已知, 随机变量$T(X)$的k阶累积量为cumulant generating function对$t$在$t=0$求$k$阶导得到的值, $A(\eta)$也满足这个关系? 那么很明显我们可以来找这两者的关系: 先写出$T(X)$的cumulant generating function, 或者看中文wiki:

所以明显有

得证.